发布日期:2022-10-17 12:44:37

发布日期:2022-10-17 12:44:37  浏览次数:0

浏览次数:0 很多人知道要做SEO推广,让用户透过搜寻得知你的产品。这主要的战场就在Google搜寻引擎上,在写内容、制定关键字策略、SEO策略前,对于Google搜寻了解这三件前备知识,你将事半功倍,在策略上拥有更大的胜率赢过其他竞品对手。

1.检索Crawl(爬取)

「检索」是Google官方文件给的正式称呼,我们通常称其为「爬取」。

在爬取阶段,指的是Google透过追踪连接、读取Sitemap等多种方法来发掘网址。Google这样做目的是寻找新网页,并为这些网页建立索引。

然而网站要成功被Google索引(收录),需要符合一些相关规则,或是你提交的文件告诉Google哪些网页可以被索引。

这份文件叫「Robot.txt」。

每个网站都被规定需要有这份文件,通常这份文件就像是一个网站的门口放的导览地图,在Google检索时,告诉google哪里可以爬取、哪里不行。 常见的应用场景:

在中国,当地母语为中文,你的Robot.txt就会请Google尽量避免爬取美国版本的网站。

2.索引Index(收录)

「索引」是Google正式官方文件的称呼,我们通常称它为「收录」。

成功被索引的网页,会收录于搜寻结果当中。想打SEO排名战,当然要让你的网站被成功索引,让潜在用户透过搜寻找到你。

网站上线第一件事:检查Google是否有收录你

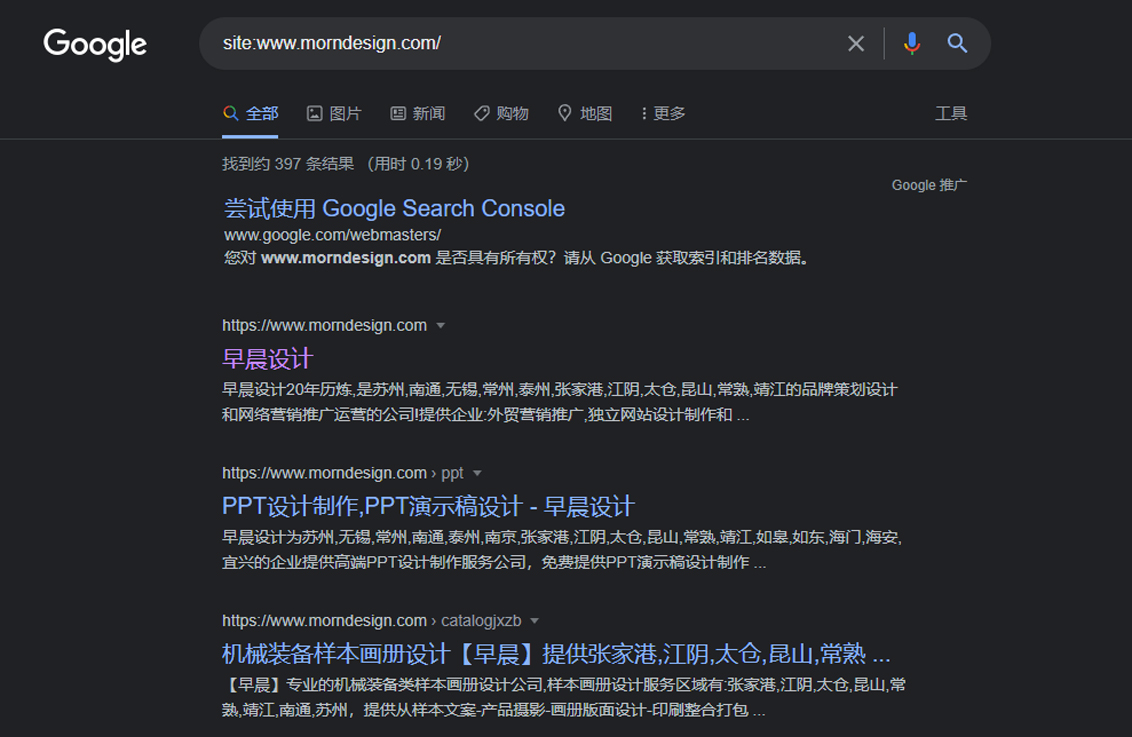

验证方法很简单,直接在搜寻列打:site:(你的网址),如果有就会显示啰。

如果没被收录,可能有以下常见原因:

尽管Google会自动检索世界上 大部分网站,但仍有漏网之鱼。你可以主动邀请Google来收录你的网站,你可以提交sitemap给Google,而Google Search Console这项工具将能帮你顺利提交。

Sitemap和Robot.txt的关系

Sitemap是个档案,Google这类搜寻引擎会读取Sitemap,知道要如何爬取您的网站信息。因此Sitemap的更新、维护和完整度会帮助Google降低检索的负担,对SEO是重要而有帮助的。

而Robot.txt是一份文字文件,你可以在Robot.txt加入Sitemap,或是运用Google Search Console直接提交你的Sitemap,都能帮助你的网页被检索。

Robot.txt和Noindex的差别

Robot.txt只能告诉Google可不可以爬取哪些页面,但不能决定哪些内容要不要被索引(收录)进Google。

如果你的网站有某些内容不想被索引,这时就需要noindex这份指令文件。noindex有点像是你的网站政策,通常放于处。

3.演算

搜寻引擎的目的,是在最短的时间内,提供最符合使用者需求的相关结果。

如今网站生成的速度越来越快、越来越多,以往常讨论到的算法类型可以明白,但不需过度针对和钻研,目前Google算法的技术已进展到相当成熟的地步,不论是熊猫、企鹅或其他算法,都能够做到「即时爬取」、「即时检索」的地步,因此现在统称为「核心算法」。

在这样的情形下,我们该专注的,是提供优质的内容给使用者,并尽量保持在技术上方便Google算法共同合作的协调性。(sitemap,Robot.txt等文件、网站政策和构架清楚。)

结语

了解Google搜寻引擎运作的原则,相信能在你生产内容、拟定内容策上有更清楚和全面的概念,拥有良好的地基,后端内容的排名战将打得更加精确、有效率。